Schon im 17. Jahrhundert haben innovative Denker Ideen von Rechenmaschinen entwickelt. Ein monumentales Buch erzählt nun (fast) die ganze Geschichte.

Die historische Entwicklung der ComputerMit dieser Geschichte hätte niemand gerechnet

Historische Computer mit Röhrenmonitoren.

Copyright: Martin Dowideit/Midjourney

Es gibt diese nette kleine Geschichte vom Vater, der seiner Tochter aus früheren Zeiten erzählt. Damals, in seiner Jugend, erklärt er dem Kind, habe er zum Beispiel keinen Computer besessen – wie überhaupt nur sehr wenige Menschen. Kaum jemand habe damals über einen Rechner verfügt. Und die Tochter antwortet: „Aber Papa, wenn ihr keinen Computer hattet, wie seid ihr denn dann ins Internet gekommen?“

Vielleicht stimmt die Geschichte, vielleicht ist sie auch nur eine Legende. Aber sie zeigt, wie wenig vorstellbar heute ein Leben ohne Computer ist. Im privaten Bereich werden sie genauso gebraucht wie in Krankenhäusern, Autos, Flugzeugen, in der Forschung, in Satelliten, bei Lieferservices. Wir finden den Weg von A nach B kaum noch ohne rechnergestütztes Navigationsgerät, das Bezahlen in Supermärkten und an Tankstellen wäre komplizierter, und der gute alte Brief braucht deutlicher länger als eine Mail oder eine Whatsapp. Kurzum: Ohne Computer läuft heute nichts mehr.

Die Zeit lässt sich nicht zurückdrehen, niemand möchte hinter den aktuellen Status quo zurückfallen. Ein Leben ohne Onlinebanking, Videokonferenzen und das Streamen von Filmen und Serien möchte sich kaum jemand noch vorstellen. Das ist ein Merkmal der Computergeschichte (wie auch von Technikgeschichte im Allgemeinen): Woran man sich gewöhnt hat, das soll bleiben.

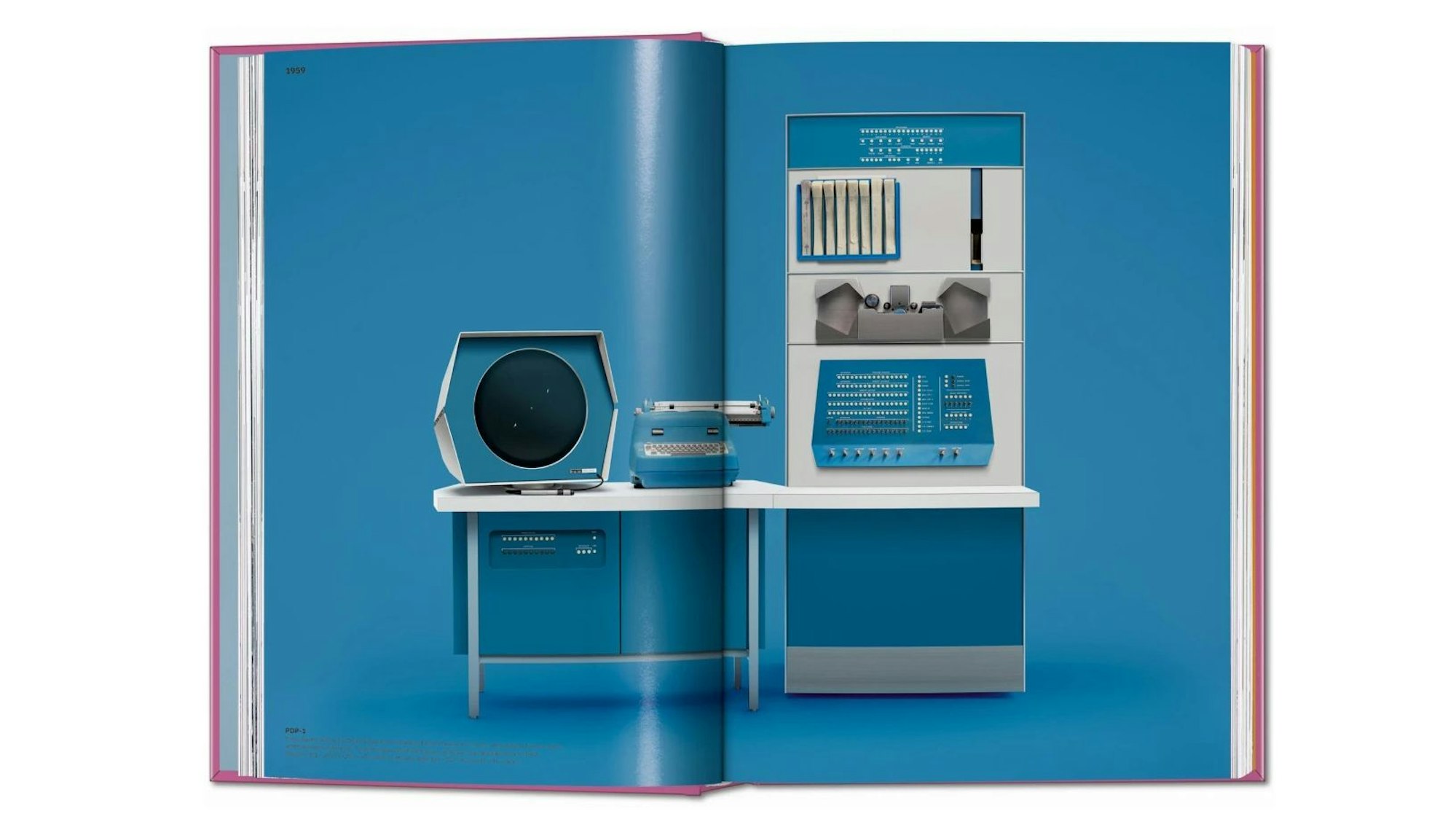

Doppelseite aus dem Buch: „The Computer. A History from the 17th Century to Today“

Copyright: Taschen-Verlag

Wann die Geschichte dieser weltverändernden Maschine begonnen hat, ist umstritten. Häufig wird Herman Hollerith genannt, der mit einem System von Lochkarten die US-Volkszählung von 1890 erleichterte. Hollerith gründete 1924 die International Business Machines Corporation, die als IBM bis in unser Jahrtausend ein großer Player in der IT-Industrie geblieben ist.

Auch der Berliner Erfinder und Unternehmer Konrad Zuse, der mit einem ersten System binärer Zahlen arbeitete, wird in diesem Zusammenhang oft genannt. „Die Idee, Signale nicht physisch umzuwandeln, wie es der Schallplattenspieler tat, sondern Worte, Schrift oder Bilder, Musik und Stimme in speicher- und übertragbare Zahlenwerte umzurechnen, eröffnete neue Welten. Die digitale Revolution konnte beginnen“, schreibt Andreas Rödder in seiner Geschichte der Gegenwart, die unter dem Titel „21.1“ bei C. H. Beck erschienen ist.

Vordenker der Computertechnik: Ada Lovelace und Charles Babbage

Eine voluminöse Geschichte des Computers ist nun im Taschen-Verlag erschienen. Auf fast 500 Seiten gehen die Herausgeber Jens Müller und Julius Wiedemann zahllosen Entwicklungssträngen dieser Maschine nach. Auch wenn die Uranfänge im 17. Jahrhundert mit den ersten mechanischen Rechenmaschinen anzusiedeln und die Autoren natürlich auch Vordenker der neuen Technologie wie Ada Lovelace und Charles Babbage nicht vergessen sind, konzentrieren sich die beiden in ihrem detailreichen Monumentalwerk auf die Geschichte der vergangenen 70 Jahre.

Ein entscheidender Faktor dabei sind Computerchips. Müller und Wiedemann zitieren Moores Gesetz. Der Intel-Mitgründer Gordon Moore formulierte „vor mehr als fünf Jahrzehnten eine Erkenntnis, die bis heute ein wesentlicher Treiber des Fortschritts der digitalen Welt ist. In einem Fachartikel prognostizierte er 1965, dass sich die Leistungsfähigkeit von Mikroprozessoren kontinuierlich in Jahresrhythmen verdoppeln werde. Die Zahlen sprechen für seine These. „Der frühe Intel-Mikroprozessor 4004 aus dem Jahr 1970 enthielt 2300 Transistoren auf einem Quadratmillimeter, während ein leistungsstarker Mikroprozessor im Jahr 2020 etwa 21.100.000.000 Transistoren auf gleichem Raum unterbringt“, heißt es in dem Buch.

Wie wichtig die kleinen Informationsträger für viele Wirtschaftszweige heute sind, zeigte in jüngster Zeit die Chipkrise. Lieferschwierigkeiten behinderten die Produktion von Autos, die ohne Massen an elektronischen Kleinbauteilen heute gar nicht mehr fahren. „Aus dem Aufstieg des Computers und der digitalen Technologie resultierte nicht nur die Entstehung der Computerindustrie selbst, sondern einer ganzen Reihe verwandter Industriezweige, die eng miteinander verknüpft sind oder auch miteinander konkurrieren, um immer komplexere und effizientere Abläufe zu entwickeln“, schreibt Julius Wiedemann.

Neue Technologie kann Märkte unerwartet auf den Kopf stellen

Jens Müller hingegen betont, dass die Computertechnologie nicht nur neue Ökonomien erzeugt oder erneuert, sondern auch zerstören kann. „Der Wirtschaftswissenschaftler Clayton M. Christensen prägte 1997 den seither gerne genutzten Begriff der disruptiven Technologie. Er beschreibt die – oft unerwartete – Veränderung von Märkten durch das Aufkommen fortschrittlicher Technik.

In der Praxis zeigt sich dieser Effekt sowohl bei Produkten als auch bei Dienstleistungen“, heißt es. Und weiter: „Ein gutes Beispiel ist die DVD-Technik, die die analoge VHS-Kassette ablöste und dann wiederum von Streaming-Anbietern überholt wurde. Das Beispiel illustriert eine zentrale Begleiterscheinung der Digitalisierung: Es bilden sich global agierende Unternehmen, die innerhalb kürzester Zeit zu scheinbar unangreifbaren Marktführern werden.

So war das digitale Angebot des Streaming-Dienstes Netflix bereits nach wenigen Jahren in 130 Ländern verfügbar. Die ehemals weltweit größte Videothekenkette Blockbuster Video betrieb auf der Höhe ihres Erfolgs 9000 Filialen in sechs Ländern.“

Aus dem Aufstieg des Computers und der digitalen Technologie resultierte nicht nur die Entstehung der Computerindustrie selbst, sondern einer ganzen Reihe verwandter Industriezweige.

So textlastig wie es erscheinen mag, ist das Buch aber gar nicht. Zu sehen sind zum Beispiel jede Menge Modelle von Rechnern. Das Buch beginnt mit dem Colossus von 1943. Dieser frühe Röhrencomputer half den Briten dabei, auf der Grundlage von Alan Turings Überlegungen verschlüsselte Nachrichten der Nationalsozialisten zu dechiffrieren. Dieser Rechner steht als Beispiel für viele Erfindungen des Computerzeitalters, die zunächst das Militär entwickelte und die erst nach und nach in zivile Kontexte überführt wurden. So war etwa das Arpanet, der Vorgänger unseres heutigen Internets, eine Erfindung der US Air Force.

Das Buch ist darüber hinaus eine einzigartige Kulturgeschichte des Computers. So bildet es alte Zeitschriften und Magazine wie das „Time“-Magazine ab. Ein „Spiegel“-Titel von 1978 zeigt die typisch deutsche Fortschrittsskepsis: „Die Computer-Revolution. Fortschritt macht arbeitslos“, heißt es dort. Die zeitgenössische Angst vor künstlicher Intelligenz klingt heute nicht anders. Es ist immer dieselbe Geschichte: Während in den USA Fortschritt als etwas Positives verstanden wird, herrscht hierzulande oft erst einmal Skepsis.

Darüber hinaus präsentiert „The Computer“ Bilder aus ganz unterschiedlichen kulturellen Bereichen. Szenen aus Filmen wie Fritz Langs „Metropolis“ sind genauso zu finden wie Buchcover etwa von Isaac Asimovs „I, Robot“. Eine fortschrittsoptimistische Werbung aus den USA von 1956 fragt: „Wie schnell werden Sie mit dem Telefon auch sehen können?“ – und prognostiziert die Videotelefonie.

Einen interaktiven Stadtführer gab es in München im Jahr 1935

Dabei fällt viel Bekanntes wie etwa die Floppy Disc und Pac Man ins Auge, aber auch Überraschendes. So stand bereits 1935 in München einer der ersten interaktiven Stadtführer. Diese geschätzt sechs Meter hohe Tafel konnte per Knopfdruck bedient werden, woraufhin touristische Ziele aufleuchteten. Mehr als 120 verschiedene Routen durch die Stadt wurden angezeigt.

Das Buch ist eine fantastische Fundgrube zur Geschichte des Computers. Zahllose Abbildungen und die Texte und Beitexte, die in Deutsch, Englisch und Französisch (manchmal auch nur in Englisch) gedruckt sind, geben nicht nur ein Überblicksbild über die Entwicklung dieser unser aller Leben verändernden Technik und Technologie. Sie leuchten auch in entlegene Winkel, in ökonomische und kulturelle Bereiche, die der Computer beeinflusst hat.

Dass diese umfassende Geschichte einer digitalen Revolution ausgerechnet in einem analogen Buch präsentiert wird, ist eine schönes Wendung. Sie ist der Beweis, dass der Computer nicht in allen Bereichen disruptiv gewirkt hat. Ein Detail für Liebhaber ist zudem, dass Teile des Buches in der IBM-Plex-Mono-Schrift gedruckt sind. Diese wurde einst als Hausschrift für das US-Unternehmen entwickelt. Die Herausgeber haben also in ihrem Opus magnum an alles gedacht.

Jens Müller, Julius Wiedemann: „The Computer. A History from the 17th Century to Today“. Taschen-Verlag, 472 Seiten, 60 Euro.

Dieser Text gehört zur Wochenend-Edition auf ksta.de. Entdecken Sie weitere spannende Artikel auf www.ksta.de/wochenende.